Parlamentares do Reino Unido alertam: Compromissos de segurança em IA estão se tornando mera fachada

- 60 legisladores do Reino Unido acusam o Google DeepMind de violar compromissos de segurança em IA ao adiar relatórios detalhados de segurança para o Gemini 2.5 Pro. - A empresa lançou um modelo de cartão simplificado três semanas após o lançamento, sem transparência sobre testes de terceiros e envolvimento de agências governamentais. - O Google afirma ter cumprido os compromissos ao publicar um relatório técnico meses depois, mas críticos argumentam que isso mina a confiança nos protocolos de segurança. - Questões semelhantes na Meta e OpenAI destacam preocupações generalizadas na indústria sobre a opacidade.

Um grupo de 60 parlamentares do Reino Unido assinou uma carta aberta acusando o Google DeepMind de não cumprir seus compromissos de segurança em IA, especialmente em relação ao atraso na divulgação de informações detalhadas de segurança para seu modelo Gemini 2.5 Pro [1]. A carta, publicada pelo grupo ativista político PauseAI, critica a empresa por não fornecer um modelo de documentação abrangente no momento do lançamento do modelo, documento essencial que detalha como o modelo foi testado e desenvolvido [1]. Eles argumentam que essa falha constitui uma violação dos Compromissos de Segurança de IA de Fronteira assumidos em uma cúpula internacional em fevereiro de 2024, onde os signatários — incluindo o Google — se comprometeram a relatar publicamente as capacidades dos modelos, avaliações de risco e envolvimento de testes de terceiros [1].

O Google lançou o Gemini 2.5 Pro em março de 2025, mas não publicou um modelo de documentação completo na época, apesar de afirmar que o modelo superava concorrentes em benchmarks importantes [1]. Em vez disso, um modelo de documentação simplificado de seis páginas foi divulgado três semanas depois, que alguns especialistas em governança de IA descreveram como insuficiente e preocupante [1]. A carta destaca que o documento carecia de detalhes substanciais sobre avaliações externas e não confirmava se agências governamentais, como o Instituto de Segurança em IA do Reino Unido, participaram dos testes [1]. Essas omissões levantam preocupações sobre a transparência das práticas de segurança da empresa.

Em resposta às críticas, um porta-voz do Google DeepMind disse anteriormente à Fortune que qualquer sugestão de que a empresa estaria descumprindo seus compromissos era "imprecisa" [1]. A empresa também afirmou em maio que um relatório técnico mais detalhado seria publicado quando a versão final da família de modelos Gemini 2.5 Pro estivesse disponível. Um relatório mais abrangente foi finalmente divulgado no final de junho, meses após a versão completa estar disponível [1]. O porta-voz reiterou que a empresa está cumprindo seus compromissos públicos, incluindo os Compromissos de Segurança de IA de Fronteira de Seul, e que o Gemini 2.5 Pro passou por rigorosas verificações de segurança, incluindo avaliações por testadores independentes [1].

A carta também observa que a ausência do modelo de documentação para o Gemini 2.5 Pro parece contradizer outros compromissos assumidos pelo Google, como os Compromissos da Casa Branca de 2023 e um Código de Conduta voluntário sobre Inteligência Artificial assinado em outubro de 2023 [1]. A situação não é exclusiva do Google. A Meta enfrentou críticas semelhantes por seu modelo de documentação mínimo e limitado para o modelo Llama 4, enquanto a OpenAI optou por não publicar um relatório de segurança para seu modelo GPT-4.1, citando seu status não-fronteira [1]. Esses acontecimentos sugerem uma tendência mais ampla na indústria, onde as divulgações de segurança estão se tornando menos transparentes ou sendo omitidas completamente.

A carta pede que o Google reafirme seus compromissos de segurança em IA, definindo claramente a implantação como o momento em que um modelo se torna acessível ao público, comprometendo-se a publicar relatórios de avaliação de segurança em um cronograma definido para todos os lançamentos futuros de modelos e fornecendo total transparência em cada lançamento ao nomear as agências governamentais e terceiros independentes envolvidos nos testes, juntamente com os cronogramas exatos dos testes [1]. Lord Browne of Ladyton, signatário da carta e membro da Câmara dos Lordes, alertou que, se as principais empresas de IA tratarem os compromissos de segurança como opcionais, isso pode levar a uma perigosa corrida para implantar sistemas de IA cada vez mais poderosos sem as devidas salvaguardas [1].

Fonte:

Aviso Legal: o conteúdo deste artigo reflete exclusivamente a opinião do autor e não representa a plataforma. Este artigo não deve servir como referência para a tomada de decisões de investimento.

Talvez também goste

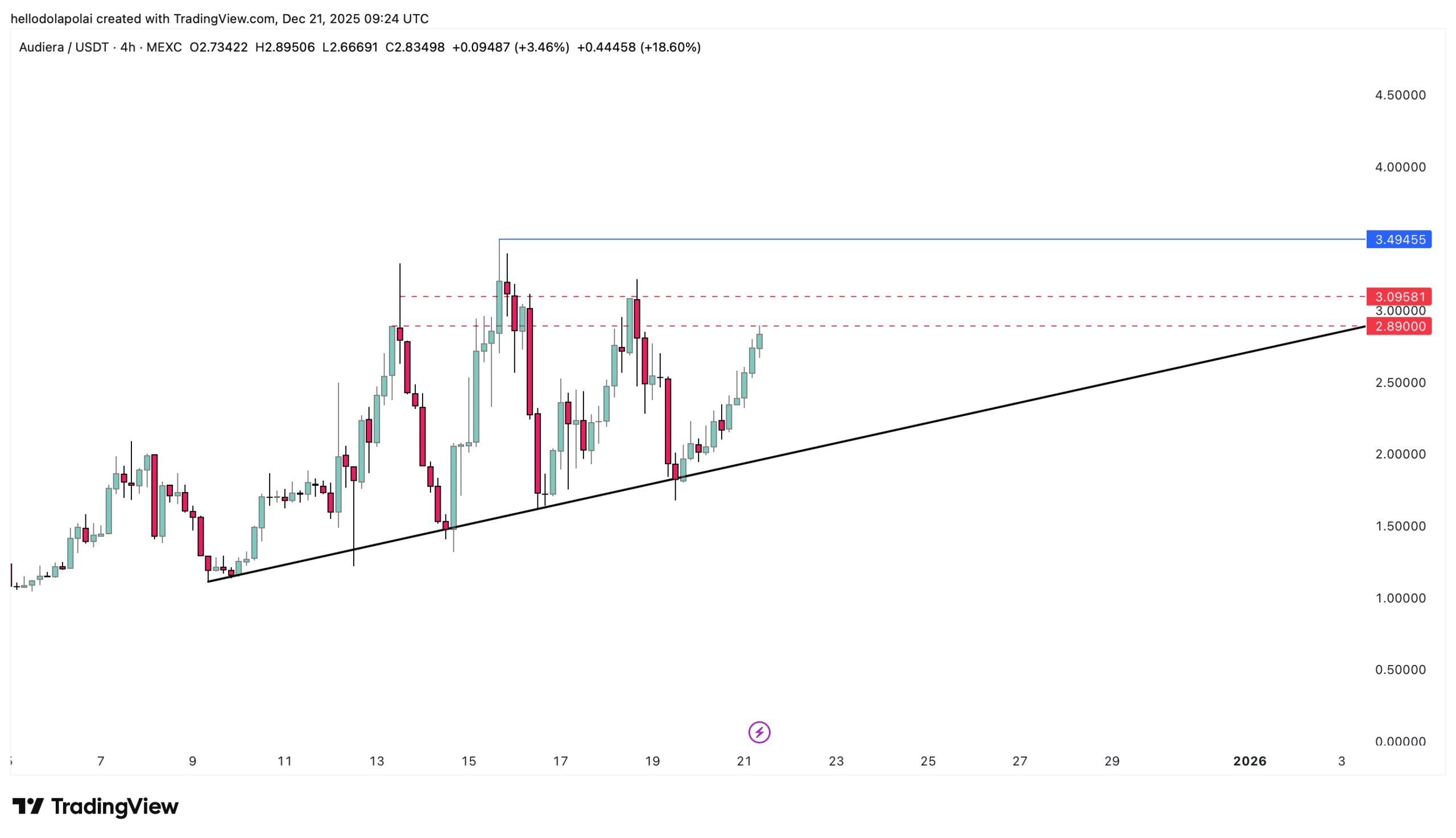

BEAT esquenta, sobe 30%! Um nível chave está diante do ATH da Audiera

Populares

MaisBitget Relatório Diário (22 de dezembro)|Câmara dos Deputados dos EUA planeja criar porto seguro fiscal para stablecoins e staking de ativos cripto; esta semana, tokens como H, XPL e SOON terão grandes desbloqueios; Índice de Força Relativa (RSI) do BTC se aproxima do menor nível em 3 anos

Bitget Relatório Matinal de Ações dos EUA|Fed sugere pausa na política; Ackman propõe plano de IPO para SpaceX; Índices de ações dos EUA se recuperam coletivamente (22 de dezembro de 2025)