Tian Yuandong: 2025 yil yakuniy hisobot (birinchi qism)

Yangi Sun'iy Intellekt Yangiliklari Hisoboti

Yangi Sun'iy Intellekt Yangiliklari Hisoboti

【Yangi Sun'iy Intellekt Yangiliklari Kirish】Llama 4’ni qutqarishga chaqirilib, keyin ishdan bo’shatilish, hozir esa startap ochish — sun’iy intellekt sohasidagi taniqli yetakchi Tian Yuandong 2025-yildagi muhim voqealarni yodga oldi.

Yaqinda juda band edim, shuning uchun yil yakuniy xulosalarini yozishni 1-yanvarga qoldirishga to'g'ri keldi. Qanday bo’lmasin, yozishni boshlashning o’zi yaxshi.

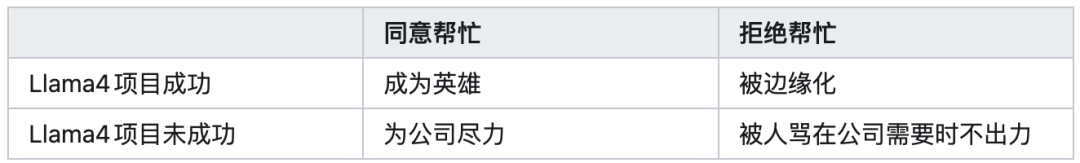

2025-yil yanvar oxiridaLlama4’ni qutqarishga chaqirilganimda, doimiy ravishda kuchaytirilgan o‘rganish (reinforcement learning) bilan shug‘ullanganim uchun oldindan 2x2 mukofot matritsasini (reward matrix) chizib, quyidagi to‘rt variantni hisoblab chiqdim (garchi o‘sha paytda yuqoridan bosim juda katta bo‘lgani uchun rad etish deyarli imkonsiz edi):

O‘sha paytda yordamga boradigan bo‘lsak, oxir-oqibat loyiha muvaffaqiyatli bo‘lmasa ham, hech bo‘lmaganda qo‘limizdan kelganini qilamiz va vijdonan toza bo‘lamiz deb o‘ylagandim. Afsuski, oxir-oqibat kutilmagan beshinchi variant yuz berdi, bu esa jamiyatning murakkabligi haqidagi tushunchamni yanada chuqurlashtirdi.

Shunga qaramay, bu bir necha oylik harakat davomida biz kuchaytirilgan o‘rganish bo‘yicha asosiy muammolarda bir qancha izlanishlar qildik, masalan, trening barqarorligi, trening va inferens o‘zaro aloqalari, model arxitekturasi dizayni, pre-trening va o‘rta trening o‘zaro ta’siri, uzoq fikrlash zanjiri algoritmlari, ma’lumotlar generatsiyasi usullari va post-trening ramkasi dizayni va boshqalar.

Bu tajriba o‘zi juda muhim bo‘lib, ilmiy izlanishlarimga katta o‘zgarish kiritdi.

Aslida, kompaniyada o‘n yil ishlaganimdan so‘ng, bir kuni baribir ketishim kerak deb ham o‘ylagandim, axir butun umr kompaniyada qolib ketib bo‘lmaydi, lekin turli iqtisodiy va oilaviy sabablarga ko‘ra doimo ishlashda davom etardim.

So‘nggi bir-ikki yilda gap-so‘z va harakatlarim, “kompaniya tezroq meni bo‘shatsa yaxshi bo‘lar edi” kayfiyati bilan o‘tmoqda, natijada borgan sari erkinlashdim.

2023-yil oxirida birinchi uzun ta’tilimni olayotganimda deyarli ketishga qaror qilgandim, lekin oxir-oqibat imzo chekmay, yana kompaniyada qolishga qaror qildim, demak, ketish qarorini qabul qilish oson emas ekan. EndiMeta bu ishni men uchun qildi, yomon bo‘lmadi.

Bu voqea va butun yil davomida bo‘lgan ko‘tarilish va pasayishlar keyingi roman yozishim uchun juda ko‘p yangi material berdi.

“Mansab yo‘li omadsiz, she’riyat omadli, hayot haddan tashqari sokin bo‘lsa, hayotda zavq ham bo‘lmas ekan.” 2021-yil boshida, yil yakuniy xulosasida “nega maqolalarim qabul qilinmayapti?” deya mulohaza yozganim uchun, Meet Most’ni oldim va birdaniga o‘zimni muvaffaqiyatsiz his qildim.

Lekin o‘ylab ko‘rsam, atrofga shikoyat qilishdan ko‘ra, o‘zimni go‘yo yangi lavozimga ko‘tarilgandek tutganim yaxshi, natijada yarim yildan so‘ng haqiqatan ham lavozimim oshdi va 21-yil boshida hech kim qiziqmaganishim 21-yil iyuldaICML Best paper honorable mention mukofotiga sazovor bo‘ldi va reprezentatsiya o‘rganish sohasida mashhur maqolaga aylandi.

22-oktabrdan keyingi vaqt davomida, asosan, mening barcha aloqa kanallarim to‘lib-toshgan holatda bo‘ldi: har kuni son-sanoqsiz xabarlar va elektron pochta, turli masofaviy uchrashuvlar yoki uchrashuv takliflari, juda band bo‘lib ketdim.

Faqat bir necha haftadan so‘ng hayot odatdagidek holatga qaytdi. Bu ikki oy davomida barchaning g‘amxo‘rligi va iliqligi uchun katta rahmat. Agar o‘sha paytda xabaringizga vaqtida javob bermagan bo‘lsam, kechirasiz.

Oxir-oqibat bir nechta takliflar oldim, o‘ylaganingiz mashhur kompaniyalar ham men bilan bog‘landi, lekin baribir yoshligimdan foydalanib, yangi startap kompaniyasiga hammuassis bo‘lishga qaror qildim. Tafsilotlarni hozircha oshkor qilmayman, avval bir oz jimjit ishlayman.

2025-yilning asosiy yo‘nalishlari — biri katta modellar inferensiyasi, ikkinchisi modelning qora qutisini ochish.

2024-yil oxirida bizning uzluksiz yashirin fazoda inferensiya (coconut, COLM’25) ishi ommaga taqdim etilgach, 2025-yilda ushbu tadqiqot yo‘nalishida to‘lqin paydo bo‘ldi. Hamma kuchaytirilgan o‘rganish va pre-treningda bu g‘oyani qanday qo‘llash, trening va hisoblash samaradorligini qanday oshirishni izlamoqda va hokazo.

Garchi bizning guruh keyinchalik llama loyihasiga jalb qilinib, katta kuch sarflay olmagan bo‘lsa-da, bu men uchun juda quvonchli holat.

Shunga qaramay, birinchi yarmida biz nazariy tahlil (Reasoning by Superposition, NeurIPS‘25) maqolasini chiqdik, unda uzluksiz yashirin fazoda inferensiyaning afzalliklari qayerda ekanini ko‘rsatdik va katta e’tibor qozondik.

Shuningdek, katta modellarning inferensiya samaradorligini oshirish haqida ham ishladik. BizningToken Assorted (ICLR’25) ishi, avval VQVAE orqali yashirin fazoda diskret tokenlarni o‘rgandi, keyin ushbu diskret tokenlarni va matn tokenlarini birga ishlatib post-training qildi, natijada inferensiya xarajatini kamaytirib, natijani yaxshiladi.

BizningDeepConf har bir yaratilgan tokenning ishonchlilik darajasini aniqlash orqali qaysi inferensiya yo‘li oldindan to‘xtatilishini belgilaydi, natijada ishlatilgan tokenlar soni ancha kamayadi, lekin ko‘pchilik ovoz berish (majority vote) ssenariysida natija yanada yaxshi bo‘ladi.

ThreadWeaver esa parallel inferensiya fikrlash zanjirlarini yaratadi va ularda post-training o‘tkazadi, shunda inferensiya tezligi oshadi. Bundan tashqari, biz dLLM’da RL asosida inferensiya modelini o‘rgatdik (Sandwiched Policy Gradient), shuningdek, kichik modellar yordamida inferensiyani o‘rganishga harakat qildik (MobileLLM-R1).

Izohliylik (explainability) borasida esa,Grokking (birdan anglash) yo‘nalishiga ikki yil oldin qiziqishni boshlagandim. Chunki ilgari men reprezentatsiya o‘rganish tahlilini qilganimda, o‘rganish dinamikasini tahlil qilib, modelda reprezentatsiya kollapsi sababi aniqlanishi mumkin edi, lekin qanday reprezentatsiya o‘rganilayotgani, ular kirish ma’lumotlari tuzilmasi bilan qanday bog‘liqligi va qanday umumlashtirish qobiliyatiga ega bo‘lishi — bular baribir jumboq edi. Grokking fenomenini tahlil qilish orqali esa, xotiradan umumlashtirishga o‘tish jarayonini o‘rganish, bu jumboqni ochishga yordam beradi.

Boshlanishda bu yo‘nalishda ishlash juda qiyin bo‘ldi va yo‘nalish yo‘q edi. 2024-yilda birinchiCOGS (NeurIPS‘25, qarangQidiruvchilar, fasl vaqti muhim emas (o‘ninchi qism)) maqolasini yozdik, lekin u faqat maxsus holatlarda tahlil qilish imkonini berdi, bundan ko‘nglim to‘lmadi.

Bir yildan ortiq chalkashlikdan so‘ng, GPT5 bilan ko‘plab muloqotlardan keyin, yaqinda yozilganProvable Scaling Laws maqolasi haqiqiy yutuq bo‘ldi, oldingi chiziqli tuzilma (NTK) ko‘ra olmagan narsalarni tahlil qila oldi va xususiyatlar paydo bo‘lishining trening dinamikasini yaxshi tushuntirib berdi. Garchi tahlil qilingan namunalar hali ham maxsus bo‘lsa-da, hech bo‘lmaganda yangi eshik ochildi. Batafsil izoh uchun qarangTian Yuandong fikrlari.

Yil oxiridagiThe path not taken maqolasi menga juda yoqdi, RL vaSFT harakatlari nima uchun bunchalik farq qilishining sababi sifatida og‘irliklar darajasida dastlabki javob berdi.

SFT haddan tashqari moslash vakatastrofik unutish (catastrophic forgetting) ga olib keladi, buni yuzaki sababi trening ma’lumotlari yetarlicha on-policy emasligi, chuqur sababi esa asosiy og‘irliklar tashqi ma’lumotlar bilan sezilarli o‘zgartiriladi, “asos” beqaror bo‘ladi va model natijasi keskin pasayadi.

RL esa on-policy ma’lumotlar asosida trening qilgani sababli, asosiy og‘irliklar o‘zgarmaydi, faqat ikkilamchi og‘irliklar o‘zgaradi, natijada katastrofik unutish muammosidan qochish mumkin, og‘irliklar tarqalishi ham nisbatan siyrak bo‘ladi (ayniqsa bf16 kvantlashda).

Ko‘pchilik izohliylik yoki “AI qanday qilib shunchalik yaxshi ishlaydi?” savoli muhim emas deb o‘ylaydi, lekin men uchun bu juda muhim. Ikkita ssenariyni tasavvur qiling:

Ssenariy bir: Agar faqat Scaling orqali AGI yoki hatto ASI ga erishsak va butun insoniyatning mehnat qadri nolgacha tushib qolsa, AI esa barcha muammolarimizni hal qilib beradigan ulkan qora qutiga aylansa, AI’ni insoniyat uchun doim yaxshilik qiladigan, aldovchi yoki yashirincha yomonlik qilmaydigan superintellekt sifatida ushlab turish ustuvor vazifaga aylanadi. Bu muammoni hal qilish uchun izohliyilik (explainability) kerak bo‘ladi.

Ssenariy ikki: Agar Scaling yo‘li oxir-oqibat ishlamasa va insoniyat eksponensial o‘sayotgan resurs ehtiyojlari oldida mag‘lub bo‘lsa, boshqa yechimlarni izlashga majbur bo‘lamiz. Shunda “model nima uchun samarali, qachon va qanday ishlamay qoladi?” savolini o‘ylashga to‘g‘ri keladi, bu fikr zanjiri orqali izohliylik (explainability) tadqiqotiga qaytish muqarrar bo‘ladi.

Ikkala holatda ham, oxir-oqibat izohliylik (explainability) kerak bo‘ladi. Hatto AI hammabilgan, hamma narsaga qodir, hamisha yaxshi bo‘lsa ham, insoniyatning qiziqishi va izlanish ruhi sabab, baribir “AI nega yaxshi ishlaydi?” degan savol o‘rganiladi.

Axir, “qora quti” — bu shubha zanjirining paydo bo‘lishi degani. Bugun katta model texnologiyasi portlab, o‘rtacha inson darajasiga yoki undan yuqori natijalarga erishayotgan bir paytda, “Uch tanlovi” asaridagiQorong‘u o‘rmon qoidalari boshqacha shaklda namoyon bo‘lishi mumkin.

Hozirda tayyor modelning qora qutisini ochib, “elektron zanjir”ni (circuit) topish hali juda dastlabki bosqichda.

Izohliylikning haqiqiy qiyin tomoni shundaki, birinchi prinsipdan — model arxitekturasi, gradient pasayishi va ma’lumotlarning o‘ziga xos tuzilmasidan boshlab, model qanday qilib bunday dekompozitsiyalangan, siyrak, past tartibli, modulli va kombinatsiyalash mumkin bo‘lgan xususiyatlarni va zanjirlarni o‘rganishini, nega ko‘p turli-tuman izohlar yuzaga kelishini, bu yuzaga kelgan tuzilmalar model treningidagi qaysi giparparametrlar bilan bog‘liqligini va qanday bog‘liqligini tushuntirish zarur.

Qachonki gradient pasayish tenglamasidan to‘g‘ridan-to‘g‘ri katta modelda xususiyatlar yuzaga kelishining muqarrarligini chiqarib olish mumkin bo‘lsa, izohliylik haqiqatan ham biologik dalil to‘plashdan fizika kabi prinsiplar asosidagi xulosaga o‘tadi. Natijada bu amaliyotni boshqaradi va keyingi avlod sun’iy intellekt modellarini loyihalash uchun yo‘l ochadi.

To‘rt yuz yil oldingi fizika bilan solishtirsak, hozir bizda ko‘plab AI versiyasidagi Tyxo Brahe’lar (ma’lumot to‘playdiganlar) va bir qancha AI versiyasidagi Kepler’lar (faraz qiluvchilar) bor, lekin hali AI versiyasidagi Nyuton (prinsiplarni kashf qiladigan) yo‘q.

O‘sha kun kelganida, ishonamanki, dunyo butunlay o‘zgaradi.

Mas'uliyatni rad etish: Ushbu maqolaning mazmuni faqat muallifning fikrini aks ettiradi va platformani hech qanday sifatda ifodalamaydi. Ushbu maqola investitsiya qarorlarini qabul qilish uchun ma'lumotnoma sifatida xizmat qilish uchun mo'ljallanmagan.

Sizga ham yoqishi mumkin

Nega Abercrombie and Fitch (ANF) aksiyalari bugun o‘smoqda

Nega bugun Lam Research (LRCX) aksiyalari o‘smoqda

Canza Finance Aptos platformasida 131 million AQSh dollari USDT ga yetdi, Afrikada AI asosidagi to‘lov protokolini joriy qildi

Seagate Technology (STX) aksiyalari ko‘tarilmoqda—Bilishingiz kerak bo‘lgan asosiy ma’lumotlar